Este tutorial faz parte do guia Getting started with Watson OpenScale

Inteligência artificial (IA) está em todos os lugares. Da Alexa em nossas casas a recomendações da Netflix, ou do mecanismo de buscas preditivas do Google a robôs cirúrgicos, esses sistemas podem sentir, argumentar, entender, aprender e interagir.

Empresas e startups inovam constantemente no desenvolvimento de aplicações melhores e mais inteligentes, já que IA concede benefícios variados às organizações. Estima-se que o mercado de inteligência artificial se torne uma indústria de US$ 190 bilhões até 2025. Entretanto, os avanços desse tipo de tecnologia podem criar novos desafios e levantar questões legais e éticas.

Hoje, IA é vista como uma espécie de caixa misteriosa que toma decisões obscuras, e as empresas podem ter dificuldades para explicar ou entender como essa capacidade é alcançada.

Por exemplo, grandes cidades chinesas estão utilizando câmeras inteligentes com reconhecimento facial baseado em inteligência artificial para detectar e identificar pedestres imprudentes (aqueles que atravessam as ruas com alta taxa de tráfego, em vez de se dirigirem aos locais mais adequados, com faixas). O nome do infrator, ainda que parcialmente coberto, e seu rosto são exibidos em uma tela pública. Acontece que o sistema cometeu um erro em Ningbo, divulgando a foto de um bilionário chamado Mingzhu Dong — falsamente reconhecido em uma campanha publicitária de um ônibus e tomado por pedestre. A respeito do caso, Dong declarou que “não foi nada”, já que detecção e reconhecimento em tempo real são desafiadores.

Mas se os resultados de um sistema de IA auxiliassem a determinar a sentença criminal a ser aplicada, permaneceria sendo um assunto sem importância? Nos Estados Unidos, tribunais podiam basear suas decisões — inclusive relacionadas a fianças e penas — sobre réus e condenados nos dados fornecidos pelo COMPAS. COMPAS é um software de avaliação de risco gerenciado por inteligência artificial utilizado para prever quais criminosos são mais propensos à reincidência. A acurácia desse recurso foi questionada quando foram notados resultados tendenciosos.

Definitivamente, tais equívocos não são questões triviais quando a segurança humana está em jogo. Em 2018, um dos carros autônomos da Uber, que estava no modo automático e tinha um motorista humano no volante por precaução, atropelou e matou uma pedestre no Arizona. Os sensores do veículo detectaram a mulher, mas “decidiram” não frear ou agir de alguma maneira. Isso levou a empresa e outras companhias, como Toyota e NVIDIA, a suspenderem testes semelhantes nos Estados Unidos.

Quanto mais a IA continua a expandir seu papel em nossas vidas e a tomar decisões por nós, uma pergunta importante não deixa de ser levantada:

Que nível de confiança podemos — e devemos — dedicar a sistemas de inteligência artificial?

Para tentar responder essa pergunta, em abril de 2019 a União Europeia divulgou uma publicação sobre diretrizes éticas para inteligência artificial. No documento, foram destacados sete aspectos essenciais de uma IA confiável. Essas diretrizes incluíam exigências como privacidade, governança de informações, diversidade e segurança.

No mesmo ano, o Smart Dubai Government anunciou o Dubai AI Principles, que expõe as expectativas da cidade e fornece um roteiro para guiar o comportamento dos sistemas baseados em inteligência artificial. O órgão também lançou o Dubai AI Ethics Guidelines para fornecer orientações para assuntos cruciais, como contabilidade e outros temas relacionados a algoritmos com IA. Inclusive, é possível experimentar a ferramenta de autoavaliação do Dubai AI Ethics Guidelines para avaliar o nível de ética de um sistema de IA a partir desses conceitos.

Quatro pilares de IA confiável

Ética na inteligência artificial é uma grande área de pesquisa da IBM. Neste artigo, são descritos quatro elementos, ou pilares, que formam a base de sistemas de IA confiáveis.

1. Explicabilidade

Trata-se de saber e entender como modelos de IA tomam decisões específicas. Ter a visibilidade de como funcionam. Por enquanto, modelos de machine learning são caixas misteriosas. Não sabemos exatamente como elas fazem as escolhas que fazem.

Ainda que seja um aspecto fundamental de uma IA confiável, implementar explicabilidade pode ser desafiador. Nesse processo, a acurácia do modelo é comprometida, já que os mais simples, facilmente interpretáveis, têm sua capacidade preditiva reduzida (por exemplo, regressão linear de árvores de decisão). Algoritmos mais poderosos e complexos, como redes neurais ou random forests, tendem a ser altamente precisos, mas difíceis de entender devido à complexidade de sua natureza.

Outro fator a ser considerado é que explicabilidade não é unidimensional. Diferentes partes interessadas gostariam de ter insights de variados aspectos do funcionamento interno de um algoritmo com base em propósitos e objetivos. Logo, explicações devem ser adaptadas.

2. Justiça

Garantir sistemas de inteligência artificial justos significa eliminar vieses nos modelos ou dados (ou pelo menos minimizá-los). Esses vieses são descritos como um desentendimento entre o treinamento de distribuição de informações criado pelo desenvolvedor e a justa distribuição esperada. Eles podem se “infiltrar” facilmente nos sistemas de IA através da criação, da coleta ou do processamento de dados. O sistema pode selecioná-los, codificá-los e ter o potencial de redimensioná-los, o que pode levar a resultados injustos (como ocorreu com o COMPAS). Algoritmos de machine learning aprendem a partir do treinamento que recebem.

Para encorajar a adoção de IA, deve-se assegurar que ela não assuma nem amplifique vieses, bem como usar dados e modelos de treinamento equitativos para evitar tratamentos injustos. Estabelecer testes para identificar, classificar e minimizar qualquer viés é fundamental para desenvolver sistemas de IA justos.

3. Robustez

A robustez se baseia em dois fatores: segurança e proteção.

A segurança de um sistema de inteligência artificial normalmente é associada à habilidade de um modelo desenvolver conhecimentos que incorporem normas societárias, políticas ou regulamentações que correspondam a comportamentos bem estabelecidos.

Já a proteção diz respeito à capacidade de defesa contra ataques maliciosos. Como qualquer software, as IA estão vulneráveis a esse tipo de ocorrência. Isso eleva a preocupação referente à segurança, visto que modelos podem ser adulterados e dados podem ser comprometidos ou deturpados.

Invasores podem se apropriar de modelos de IA estudando seus outputs ou enganando o algoritmo por meio da introdução de ruídos ou perturbações contraditórias. Caso acredite que isso é complicado, confira o artigo One Pixel Attack for Fooling Deep Neural Networks, que descreve como uma rede neural profunda identifica imagens incorretamente quando um pixel — isso mesmo, apenas um pixel — é modificado.

A segurança pode ser aprimorada com a exposição e a correção de vulnerabilidades no sistema, possibilitando a identificação de novos ataques e defesas e a estruturação de novos métodos de treinamento contra invasores para fortalecimento do modelo, além da criação de novas métricas de avaliação da robustez.

4. Linhagem

Sistemas de inteligência artificial estão em constante evolução. Linhagem diz respeito à possibilidade de rastrear e manter a origem de datasets, metadados, modelos com seus hiperparâmetros e resultados de testes. Rastreabilidade é crucial para que órgãos reguladores, organizações apropriadas, terceiros e usuários auditem o sistema e possam reproduzir outputs passados e identificar resultados.

A característica pode auxiliar na descoberta da versão exata do serviço e sua implementação em qualquer ponto de sua história, assim como evidenciar quantas vezes o sistema foi treinado e seus detalhes de modificação, como a quantidade de metadados modificados no episódio do treinamento, dataset de treinamento utilizado, acurácia e segurança das métricas em sua evolução, feedback fornecido e motivos para reciclagem e aprimoramento.

Ferramentas

Agora que você sabe a importância de gerar confiança em sistemas de inteligência artificial e os fatores que os influenciam, vamos conferir ferramentas que o auxiliarão a implementar essa característica em seus serviços.

Watson OpenScale

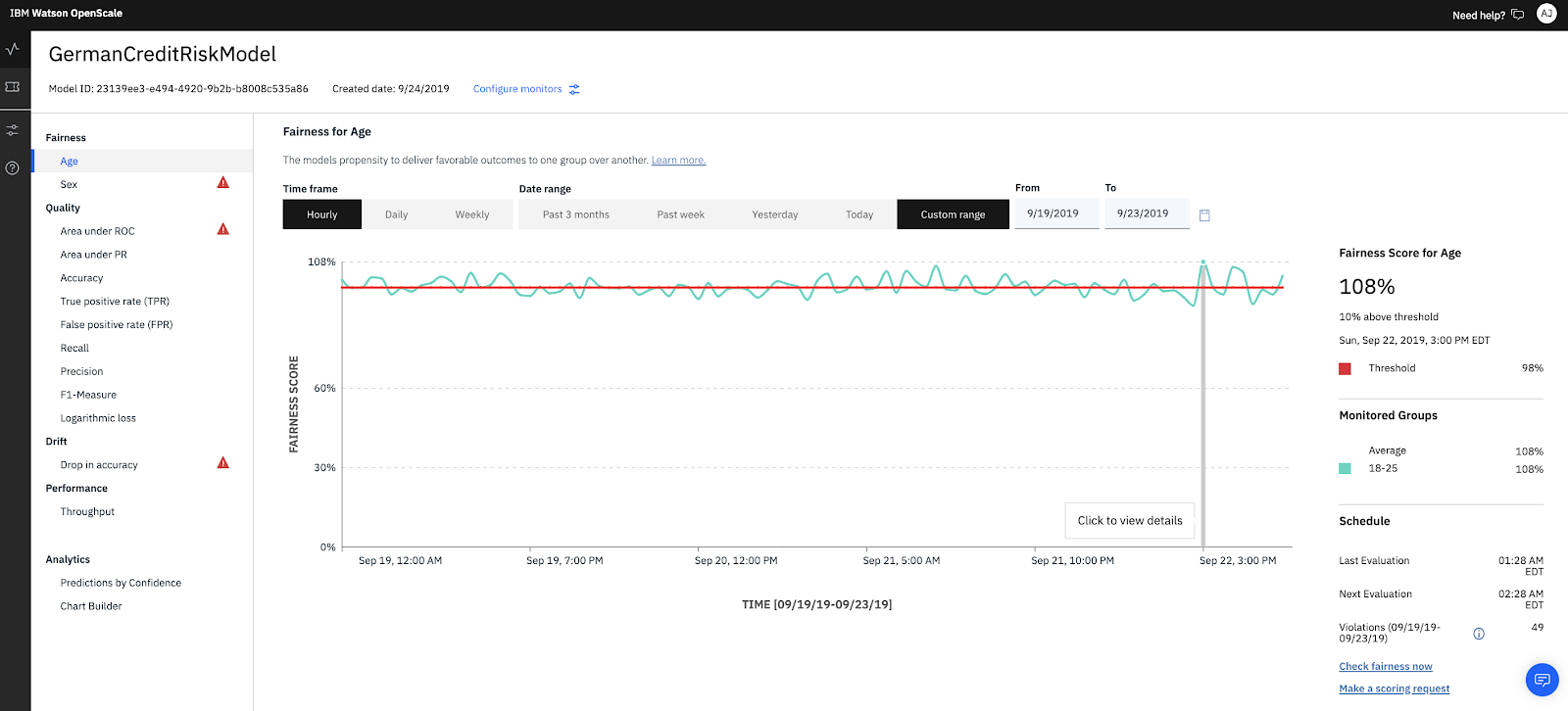

Ambiente de nível corporativo para aplicações AI-infused que oferece às empresas visibilidade de como a IA está sendo construída e usada, o OpenScale traz clareza de informações e pode detectar e atenuar vieses, ajudar a explicar os resultados da IA, escalar o uso do modelo e fornecer insights sobre a integridade do sistema, além de fornecer ROI — tudo dentro de um cenário de gerenciamento unificado.

AI Explainability 360

O toolkit AI Explainability 360 é um pacote open source Python que pode ajudar na compreensão de como modelos de machine learning preveem labels de diversas maneiras durante o ciclo de vida da aplicação de IA. São incluídos algoritmos compatíveis com a interpretabilidade e a explicabilidade de datasets e modelos de aprendizado de máquina.

Adversarial Robustness 360 Toolbox

Pacote open source Python para machine learning adversária que auxilia na defesa de redes neurais profundas contra ataques maliciosos, tornando sistemas de IA mais seguros. Seu propósito é permitir a rápida elaboração e análise de métodos de ataque e defesa para modelos de machine learning. Adversarial Robustness 360 Toolbox fornece a implementação para muitos métodos de ponta para ataque e defesa.

AI Fairness 360

Pacote open source Python para auxiliar na detecção e na remoção de vieses de modelos de machine learning. Inclui um conjunto abrangente de métricas para datasets e modelos para testar e explicar vieses, além de algoritmos para minimizá-los.

OpenScale versus AI Fairness 360

Conclusão

Este artigo explicou como vieses e ataques podem afetar sistemas de inteligência artificial. Além disso, forneceu diversos exemplos de como tais ações podem ocorrer, indicando ferramentas para minimizar os problemas

Esta é uma parte do guia Getting started with Watson OpenScale. Para continuar o aprendizado, confira IBM Watson OpenScale and AI Fairness 360: Two new AI analysis tools that work great together. Depois, acesse o tutorial Getting started with Watson OpenScale.

...

Quer ler mais conteúdo especializado de programação? Conheça a IBM Blue Profile e tenha acesso a matérias exclusivas, novas jornadas de conhecimento e testes personalizados. Confira agora mesmo, consiga as badges e dê um upgrade na sua carreira!

.....

Participe da Maratona Behind the Code 2020, um desafio para desenvolvedores e entusiastas da tecnologia! Além de concorrer a prêmios, você ainda tem acesso a conteúdos e serviços gratuitos. Não perca essa chance, as inscrições vão até 7 de agosto!

Categorias