Não é de hoje que as grandes empresas de tecnologia tentam encontrar uma solução para lidar com comentários tóxicos na internet. Em muitos casos, a principal aposta dessas companhias vem sendo o desenvolvimento de uma inteligência artificial capaz de detectar automaticamente se uma frase contém discurso de ódio e realizar todo o trabalho de moderação sem intervenção humana.

É a pretensão do Google para o Perspective, uma ferramenta criada pela Jigsaw, incubadora de tecnologia que faz parte da Alphabet. Ela utiliza aprendizado de máquina para “ler” comentários publicados em redes sociais e medir o nível de toxicidade encontrado ali. Atualmente, o Perspective pode ser testado nos sites YouTube, Twitter, Facebook, Reddit e Disqus através da extensão Tune para Google Chrome.

Tecnologia, negócios e comportamento sob um olhar crítico.

Assine já o The BRIEF, a newsletter diária que te deixa por dentro de tudo

Mas esse uso de machine learning pode acabar tendo o efeito contrário, ajudando a silenciar minorias e sendo ineficiente contra comentários racistas. É o que mostram os pesquisadores do InternetLab, centro de pesquisas brasileiro que realiza estudos na área de tecnologia e direito. Eles utilizaram o Perspective para analisar comentários feitos por “pessoas com discurso extremamente controverso ou muito tóxico” e por drag queens que participaram do reality show RuPaul's Drag Race.

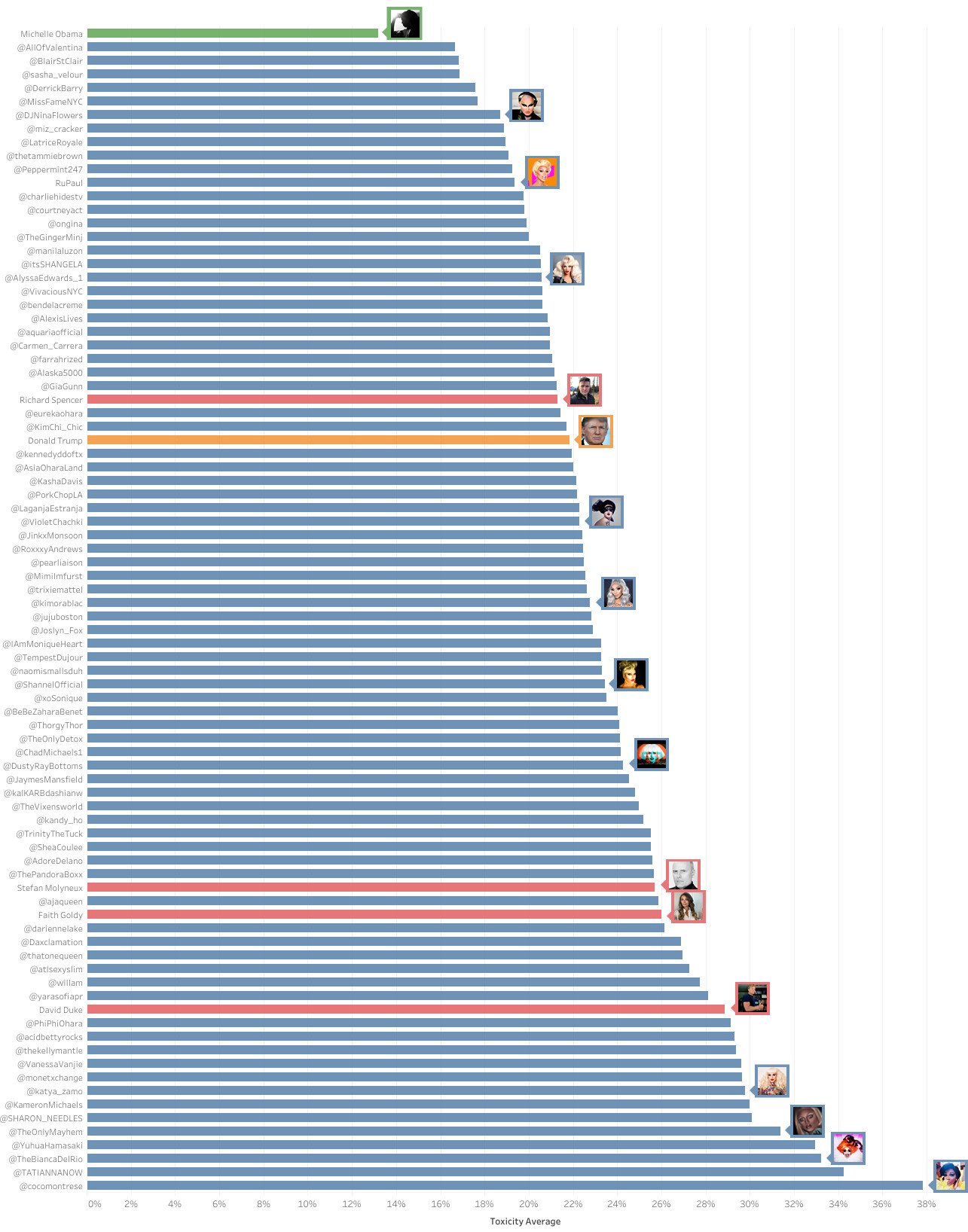

Após analisar 114.204 tweets, coletados com a ajuda de um algoritmo python, as mensagens foram submetidas à API do Perspective e receberam um nível de toxicidade que pode variar entre 0% e 100%. Como você pode ver no gráfico abaixo (clique para ver no tamanho original), algumas drag queens foram consideradas mais tóxicas do que supremacistas brancos dos EUA como David Duke, ex-líder da Klu Klux Klan.

A pesquisa mostra que o algoritmo considerou como tóxicas diversas palavras usadas com frequência por pessoas da comunidade LGBTQ para conversarem entre si. Termos e gírias como fag, bitch, sissy, e queer receberam níveis de toxicidade entre 51% e 98%. Embora várias dessas palavras possam ser usadas de forma ofensiva, elas foram apropriadas pelas minorias “para lidar com hostilidade externa ao grupo”.

“Nossa análise qualitativa de tweets individuais ilustram como esses vieses têm implicações significativas para o discurso LGBTQ”, diz o texto publicado pelo InternetLab. A mensagem “Oi gays de Austin!!!! Venham me ver no @oilcanharrys essa noite!!!”, por exemplo, publicada pela drag Yuhua Hamasaki recebeu 93% de nível de toxicidade.

Exemplo de tweet que a IA do Google considerou como 94% tóxico. (Fonte: InternetLab/Reprodução)

Exemplo de tweet que a IA do Google considerou como 94% tóxico. (Fonte: InternetLab/Reprodução)

Por outro lado, tweets com comentários racistas não foram considerados tão tóxicos pelo Perspective. Um exemplo é o tweet de um youtuber afirmando que “as três principais raças têm volumes cerebrais e médias de QI diferentes”. Para o algoritmo, essa frase tem nível de toxicidade de apenas 21%. Algo parecido aconteceu com uma mensagem de David Duke contra imigrantes, que recebeu apenas 7% de toxicidade.

Tweet com nível de toxicidade de 6%. (Fonte: InternetLab/Reprodução)

Tweet com nível de toxicidade de 6%. (Fonte: InternetLab/Reprodução)

Os pesquisadores do InternetLab concluem que é preciso “haver discussão mais profunda sobre como essas ferramentas podem impactar, modificar e modelar a forma por meio da qual nós todos nos comunicamos”. O centro de pesquisas promete publicar um artigo acadêmico em breve com metodologia, dados e resultados completos do estudo.

Fontes

Categorias