Os vídeos do jornalista Bruno Sartori fazem sucesso como crítica virulenta ao governo do presidente Jair Bolsonaro. A técnica usada por ele é popularmente conhecida como deepfake (mídia manipulada e criada usando-se inteligência artificial). Mas aquilo que faz rir também está tirando o sono de especialistas em segurança do mundo digital.

Se, há um ano, todo o processo para se produzir deepfakes era demorado e o resultado, insatisfatório, hoje são necessários dias para se obter um vídeo de qualidade razoável.

Qualquer um pode fazer deepfakes. Enquanto o TikTok está trabalhando em seu próprio recurso, o Zao, lançado em fins de 2019 para iOS, já é um dos mais populares apps da Apple Store. O Snapchat tem o Cameo para troca de rostos de GIFs, a mesma funcionalidade do Doublicat.

Deepfakes como commodities

“A capacidade de se fazer deepfakes está se tornando uma commodity. O Snapchat pagou US$ 166 milhões pela AI Factory, a empresa por trás do seu recurso Cameo”, contou ao Mashable o CEO da consultoria digital CREOpoint, Jean-Claude Goldenstein.

Para a empresa de relações-públicas Marathon Strategies, deepfakes são engraçados até causarem problemas. “Eles podem arruinar a reputação de qualquer um. Figuras públicas precisam se preparar para essas ameaças”, disse o CEO Phil Singer ao mesmo site. O vídeo do ex-presidente Obama afirmando que Donald Trump "é um imbecil" é um bom exemplo.

Atriz pornô sem nunca ter tirado a roupa

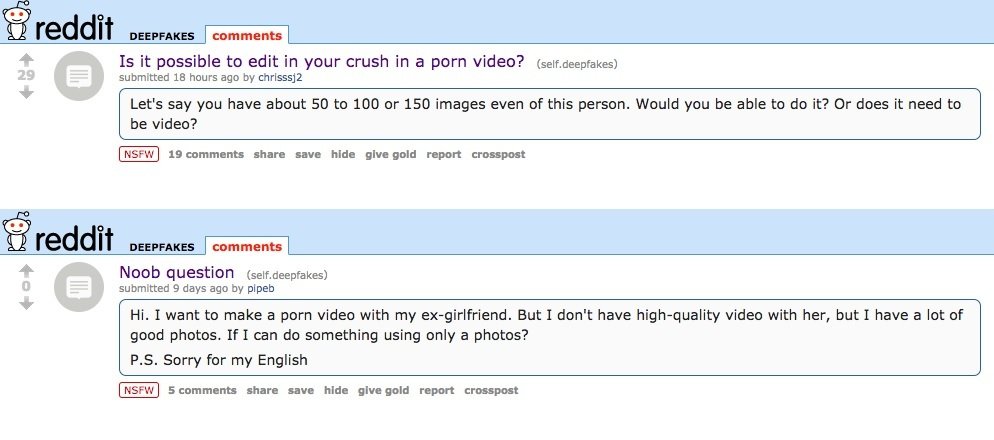

“Deepfakes” era o nome de um membro do Reddit que tinha um hobby: inserir o rosto de atrizes famosas como Gal Gadot, Maisie Williams e Taylor Swifts sobre o de estrelas do pornô.

Quando “deepfakes” começou a ganhar admiradores e imitadores, o Reddit baniu a prática e criou regras para o uso do recurso. "Se antes eram nossos dados, agora chegou a vez de nos preocuparmos com o que é feito com as imagens pessoais”, explicou Singer.

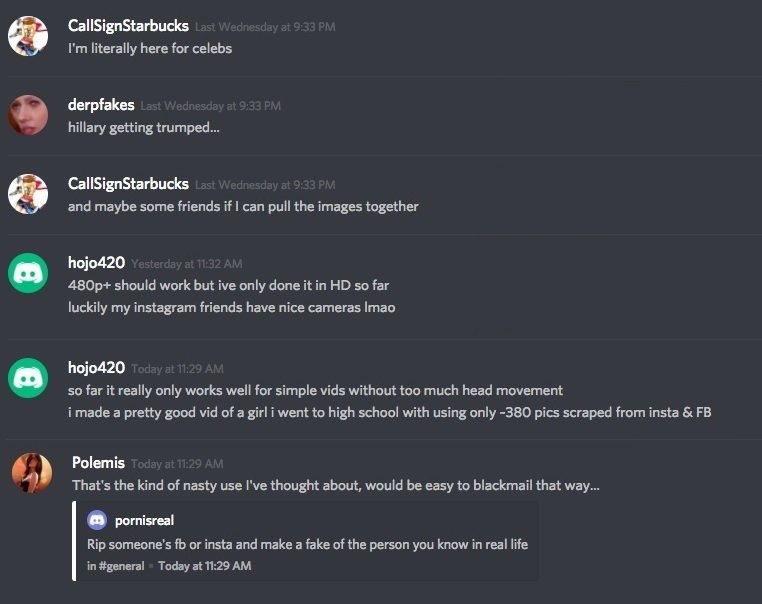

Pessoas comuns também são atingidas. A revista eletrônica Vice foi a primeira a mostrar como deepfakes podem ser usados na chamada “pornografia de vingança”: a vítima “atuaria” em filmes de sexo explícito sem jamais ter tirado a roupa em frente às câmeras.

Imagens coletadas em contas abertas do Facebook e do Instagram estão sendo usadas em pornôs, inserindo-se o rosto de colegas de escola, trabalho, professores, vizinhos, amigos. Com o aperfeiçoamento da tecnologia, esse vídeos podem um dia voltar para a vida do retratado involuntário quando ele perder a vaga de um emprego, uma bolsa de estudos ou até mesmo um cargo público.

Redes começam a contra-atacar

As redes sociais e de conteúdo já perceberam a grande ameaça que o recurso representa. Facebook, Instagram, Reddit, Amazon, Microsoft, AWS e uma dúzia de universidades americanas (como Cornell Tech, MIT e Oxford) se uniram em uma iniciativa chamada DeepFake Detection (DFDC, ou Detecção de Deepfake).

As empresas disponibilizaram US$ 10 milhões, entre outros recursos, para ajudar a criar ferramentas de detecção de deepfakes. Além disso, as normas de conduta estão mudando para restringir cada vez mais o uso do recurso em redes sociais.

A iniciativa chega em boa hora, mas tarde, e a política da comunidade está cheia de brechas: o Facebook, por exemplo, cobre apenas mídias editadas que incluem fala. Como o jornalista Will Oremus observou no site OneZero, “deepfakes mostrando um político apertando a mão de um terrorista não seriam proibidos”. Mesmo sendo o próprio Mark Zuckerberg vítima de um deepfake (que ainda está no ar), o Facebook confirmou a afirmação.

Categorias